Gli a/b test stanno all’advertising come io sto ai Lego. Andiamo assieme e non c’è nulla da fare, non ci si può dividere.

Per migliorare costantemente le performance conosco un unico approccio che funziona davvero. Formuli un’ipotesi, raccogli dati, li analizzi, prendi una decisione e ripeti il processo.

Il succo di fare a/b testing è questo e dovrebbe essere la base di chiunque faccia marketing.

Non potrai mai sapere quale messaggio è più efficace, quale targeting è più corretto o quale obiettivo di ottimizzazione è più efficiente a priori. Ogni business specifico ha le proprie regole ed è proprio per questo che l’advertising non mi stanca mai.

Imparo sempre qualcosa di nuovo. Oggi ti racconto come approccio io gli a/b test e quali sono le cose principali da tenere a mente per essere sicuri di testare in modo efficace le tue ipotesi.

Non mi dilungo oltre. Si comincia!

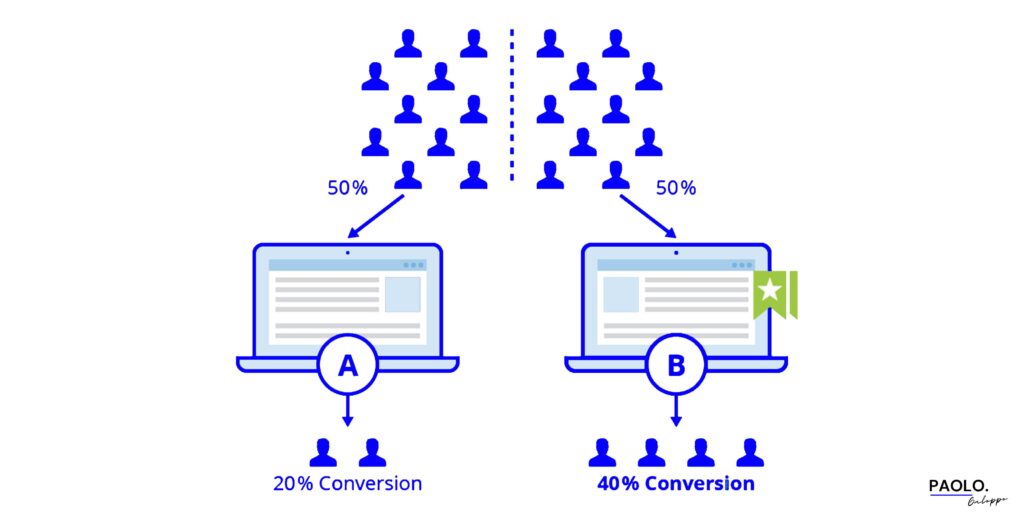

Dovresti averlo già capito dall’introduzione e probabilmente, visto che sei del settore, sai già di cosa parlo ma è bene evitare fraintendimenti. Un a/b test per essere tale deve avere tre caratteristiche fondamentali:

Se anche solo una di queste condizioni non si verifica molto probabilmente hai perso tempo e gli insights che speravi di ricavare non sono affidabili. E questo vale per qualsiasi test a qualsiasi livello del funnel.

Sia che tu stia testando due landing page o altre variabili post click, sia che tu stia testando angoli comunicativi in pre click queste caratteristiche sono centrali.

Il perché è molto semplice:

Tra poco ti mostrerò come far sì che queste condizioni siano rispettate. Prima però, una veloce panoramica dei due approcci che puoi utilizzare.

Quando fai a/b testing tendenzialmente hai due strade, ognuna con pro e contro. La prima è utilizzare un approccio “empirico”, la seconda è avere invece un approccio “scientifico”.

Nel primo caso l’a/b test non avviene andando a distinguere e isolare un gruppo di controllo e un gruppo di test. Nel 70% dei casi a livello di advertising gli esperimenti si svolgono con questa modalità.

Per spiegarti meglio ti faccio un esempio pratico. Immagina di voler testare due leve comunicative differenti. Il tuo processo, banalizzando, potrebbe essere:

Un processo di questo tipo ha sicuramente dei vantaggi:

Ma c’è anche un grande contro (te pareva). Il rumore nei dati è maggiore perché non isoli celle distinte a livello di target e quindi probabilmente i risultati sono meno rigorosi.

P.s. Se vuoi approfondire il testing creativo ti lascio qui e qui due articoli che ho scritto in passato sul tema.

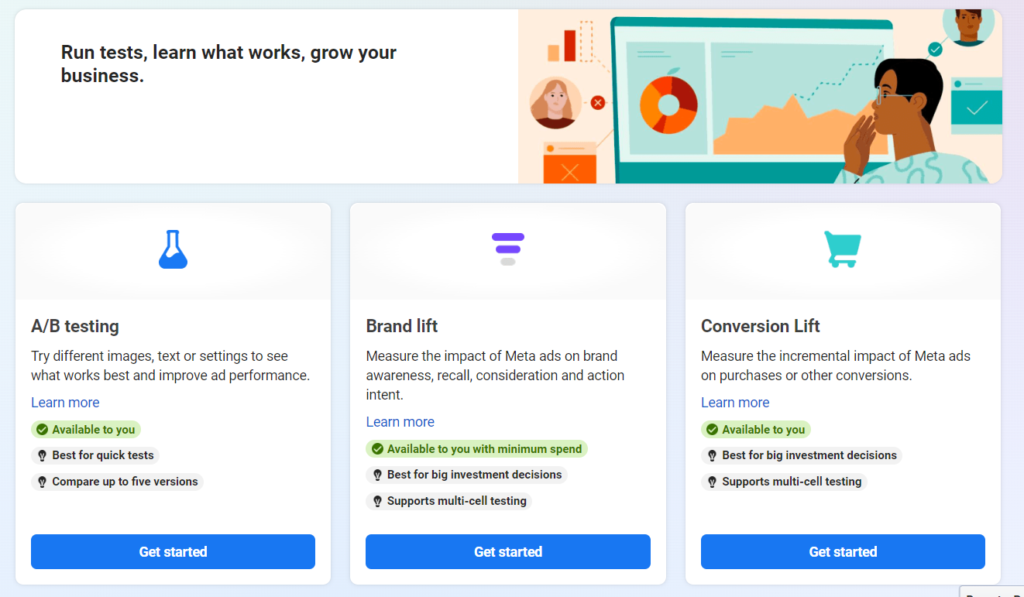

In questa seconda casistica invece l’a/b test viene condotto utilizzando degli strumenti in grado di rendere più rigoroso il processo e di isolare gruppi sperimentali e gruppi di controllo.

Se parliamo di a/b testing in pre click ogni piattaforma di advertising, anche se in pochi lo sanno, ha la possibilità di creare dei veri e propri esperimenti dove la delivery è controllata in modo tale che le persone presenti all’interno del target 1 non potranno essere presenti anche nel target 2.

Nell’esempio di prima quindi avremo la certezza che non ci sono persone che hanno visualizzato entrambe le leve comunicative e quindi avremo il grosso vantaggio di ridurre il rumore nei dati perché non potranno esserci casi in cui la conversione è da attribuire con pesi diversi a entrambe le leve.

Di contro però avremo:

Quindi come scegliere tra i due metodi? Personalmente per le ipotesi da testare nel day by day come quella d’esempio adotto il primo metodo che è più veloce e scalabile.

Mentre se devo testare variabili più macro come per esempio l’efficacia di affiancare campagne di upper funnel a quelle di lower funnel vado di metodo scientifico.

Nella mia esperienza ci sono 3 costanti che mi hanno portato nel corso degli anni a fare a/b testing in modo efficace e che sono arrivate a costituire il metodo che uso tutt’ora.

Penso siano 3 punti fondamentali se vuoi davvero ottenere risultati in maniera costante e continuativa.

Identificare le priorità ti consente di concentrarti sulle variabili a maggior impatto e di delineare un vero e proprio piano di testing strutturato. Immaginatelo come un vero e proprio piano editoriale di testing.

Per riuscire poi a replicare in modo costante il processo non c’è altra via se non cercare di standardizzare il più possibile i suoi passaggi. Costruire un proprio framework di testing con tutti gli step da compiere per portarlo a termine è centrale per rendere l’a/b testing davvero scalabile e non limitarsi a farli così di tanto in tanto.

In ultimo, vedo spesso advertiser che si mettono a testare varianti del colore del bottone sulla landing ma che non sanno quali sono le leve di comunicazione più efficaci. Ecco, evita di essere uno di loro e parti dal testare variabili macro che hanno un grande impatto.

Se parliamo per esempio di landing page per lead generation potrebbe essere il confrontare una struttura molto lunga con una molto corta o modificare il numero di campi del form oppure ancora dividere il form in più step.

Parti da variabili di questo tipo e solo quando avrai un’idea chiara di cosa funziona davvero a livello macro inizia ad andare in dettaglio.

A questo punto avendo capito quali sono i pilastri per un a/b testing efficace e sostenibile nel tempo l’elenco degli errori da evitare dovrebbe venirti naturale.

Nel dubbio:

In sintesi, come sempre nella vita, usa un po’ di buon senso e vedrai che riuscirai progressivamente a migliorare le performance dei tuoi account.

Se sei alla ricerca della ricetta per migliorare l’hai trovata. Olio di gomito e a/b test a profusione. Mi spiace se non è una formula magica che in 30 secondi ti porta i risultati ma è così. Da qui non si scappa checché ne dicano i vari guru del dropshipping.

(Pacca sulla spalla a me che sono riuscito a usare “checché” in un articolo)

Qui ti si apre un mondo. Mondo che per semplicità ti dividerò in due:

E anche qui hai un bivio perché potresti decidere di affidarti a tool esterni come Smartly, che però costa una sassata e ha senso solo da certe dimensioni di investimento, oppure di andare con i tool interni alle piattaforme.

Tendenzialmente ti consiglio la seconda strada perché più agile e meno costosa (letteralmente).

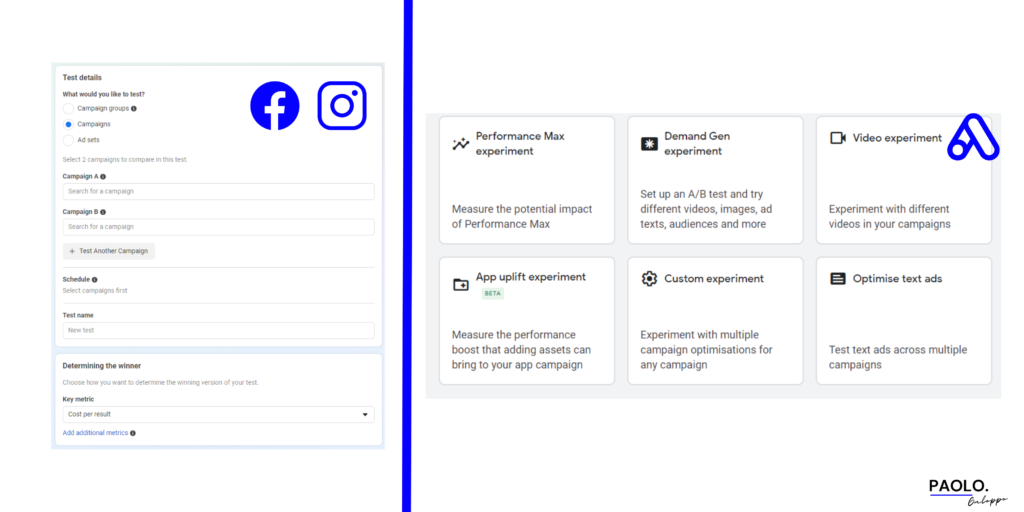

Puoi trovare queste funzionalità sia su Meta che Google Ads e a livello di struttura più o meno sono simili.

Su Meta:

Su Google:

Cambiano invece molto a livello di possibilità di testing. Se sei interessato a capirne di più fammelo sapere che sto pensando di fare un articolo dedicato a riguardo.

Fino a qualche mese fa ti avrei detto serenamente di partire utilizzando Google Optimize ma come forse saprai è defunto.

Questo significa che per fare testing sulle landing hai due strade principali:

Se sei un bello smanettone e non hai molto budget ti consiglio la prima. Altrimenti ecco qualche tool che ritengo valido:

Scegli quello che si adatta di volta in volta meglio alla tua situazione

Avere un processo di testing strutturato ti consentirà di migliorare in modo costante i risultati. Non esistono scorciatoie ma se applichi quello che hai imparato in questo articolo sono sicuro che migliorerai nel tempo.

Per me è stato così. Quindi ricorda:

Direi che anche per questo giovedì è tutto. Se hai dubbi o domande scrivimi, mi farà piacere aiutarti!

Sei arrivato fin qui quindi probabilmente questi argomenti ti interessano.

Per non perdere nessun articolo puoi iscriverti gratis alla newsletter che trovi qui sotto.

In ogni caso, alla prossima!

Copyright © Paolo Galoppo. All Rights Reserved.

Designed by Eye Studios